大语言模型中的心智理论:评估与增强

原标题: Theory of Mind in Large Language Models: Assessment and Enhancement 作者: Ruirui Chen, Weifeng Jiang, Chengwei Qin, Cheston Tan 机构: A*STAR 高性能计算研究所、前沿AI研究中心(新加坡);南洋理工大学;香港科技大学(广州) 发表: ACL 2025(第63届计算语言学协会年会) 链接: ACL Anthology

一句话总结

这是一篇关于大语言模型(LLM)心智理论(ToM)能力的综合综述,系统梳理了 2023-2024 年间提出的评估基准和增强策略,为研究者提供了该领域的全景图。

1. 研究背景

什么是心智理论(Theory of Mind)?

通俗解释:心智理论就是"读心术"——理解他人在想什么、相信什么、想要什么的能力。

生活化比喻:

- 你看到朋友盯着蛋糕店橱窗,就能猜到他可能想吃蛋糕(推断欲望)

- 你知道惊喜派对的秘密,但知道寿星不知道(理解信念差异)

- 你能听出"真棒啊"是真心夸奖还是讽刺(理解非字面沟通)

学术定义:ToM 是将心理状态(如情感、意图、信念)归因于自己和他人的能力 (Premack & Woodruff, 1978)。

为什么研究 LLM 的 ToM 能力重要?

- 实际应用:LLM 越来越多地与人类互动,理解用户意图至关重要

- 安全对齐:需要了解 AI 能否真正理解人类心理状态

- 认知科学:探索 AI 是否具有某种形式的"理解"能力

当前争议

| 观点 | 代表性研究 |

|---|---|

| LLM 展现出 ToM 能力 | Bubeck et al., 2023; Kosinski, 2024; Street et al., 2024 |

| ToM 能力肤浅且不稳定 | Shapira et al., 2024; Ullman, 2023; Ma et al., 2023a |

2. 核心贡献

本综述的三大贡献:

- 首个全面综述:同时覆盖 ToM 评估和增强两个方面

- 深度分析:追踪基准测试的演化脉络和策略发展

- 未来方向:指出基准开发和策略优化的研究方向

3. 心智理论基础概念

3.1 ATOMS 框架:七种心理状态

根据 Beaudoin et al. (2020) 的定义,心智理论涉及七种心理状态:

| 心理状态 | 英文 | 说明 | 示例 |

|---|---|---|---|

| 信念 | Beliefs | 个体对现实的假设或解释 | "Sally 认为弹珠在篮子里" |

| 意图 | Intentions | 行为背后的计划或动机 | "他打算去超市买牛奶" |

| 欲望 | Desires | 个体想要或希望达成的事 | "她想要那块蛋糕" |

| 情感 | Emotions | 个体体验的情绪 | "他因为失败感到沮丧" |

| 知识 | Knowledge | 个体积累的事实信息 | "她知道巴黎是法国首都" |

| 感知 | Percepts | 个体的感官信息或观察 | "他看到了藏起来的礼物" |

| 非字面沟通 | Non-literal | 比喻、讽刺、暗示等 | "这真是太'棒'了"(讽刺) |

3.2 关键术语

阶(Orders):回答问题所需的心理状态归因层数

一阶问题:"Sally 会去哪里找她的弹珠?"

→ 只需推断 Sally 的信念

二阶问题:"Anne 认为 Sally 会去哪里找弹珠?"

→ 需要推断 Anne 对 Sally 信念的信念

三阶问题:"Bob 认为 Anne 认为 Sally 会去哪里找?"

→ 更深层嵌套真信念 vs 假信念:

- 真信念:Sally 的信念与现实一致

- 假信念:Sally 的信念与现实不一致(更难测试)

4. 评估框架总览

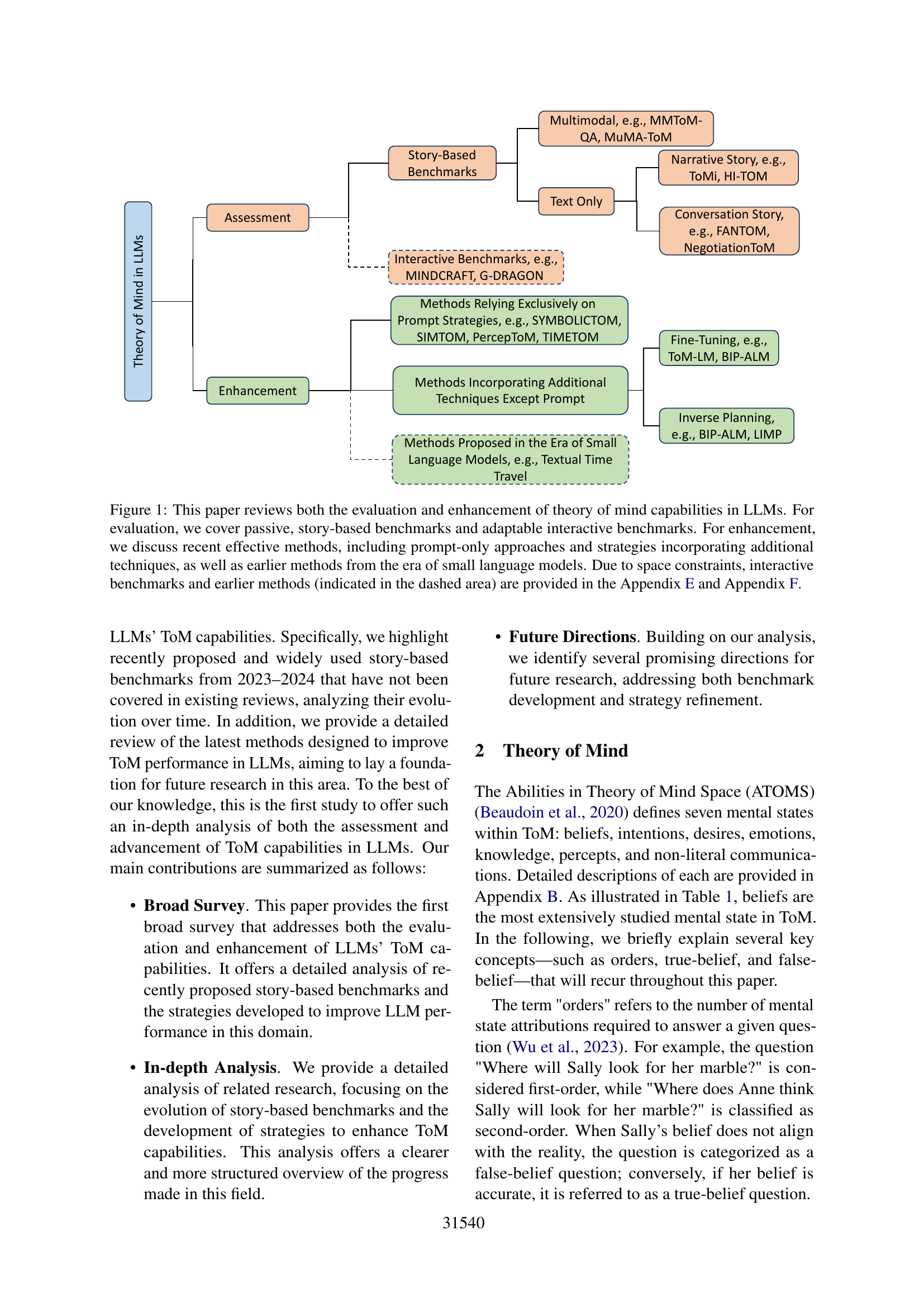

图1:本综述的研究框架,涵盖评估(基于故事的基准、交互式基准)和增强(仅提示策略、额外技术)两大方面

5. ToM 评估基准详解

5.1 经典心理学测试

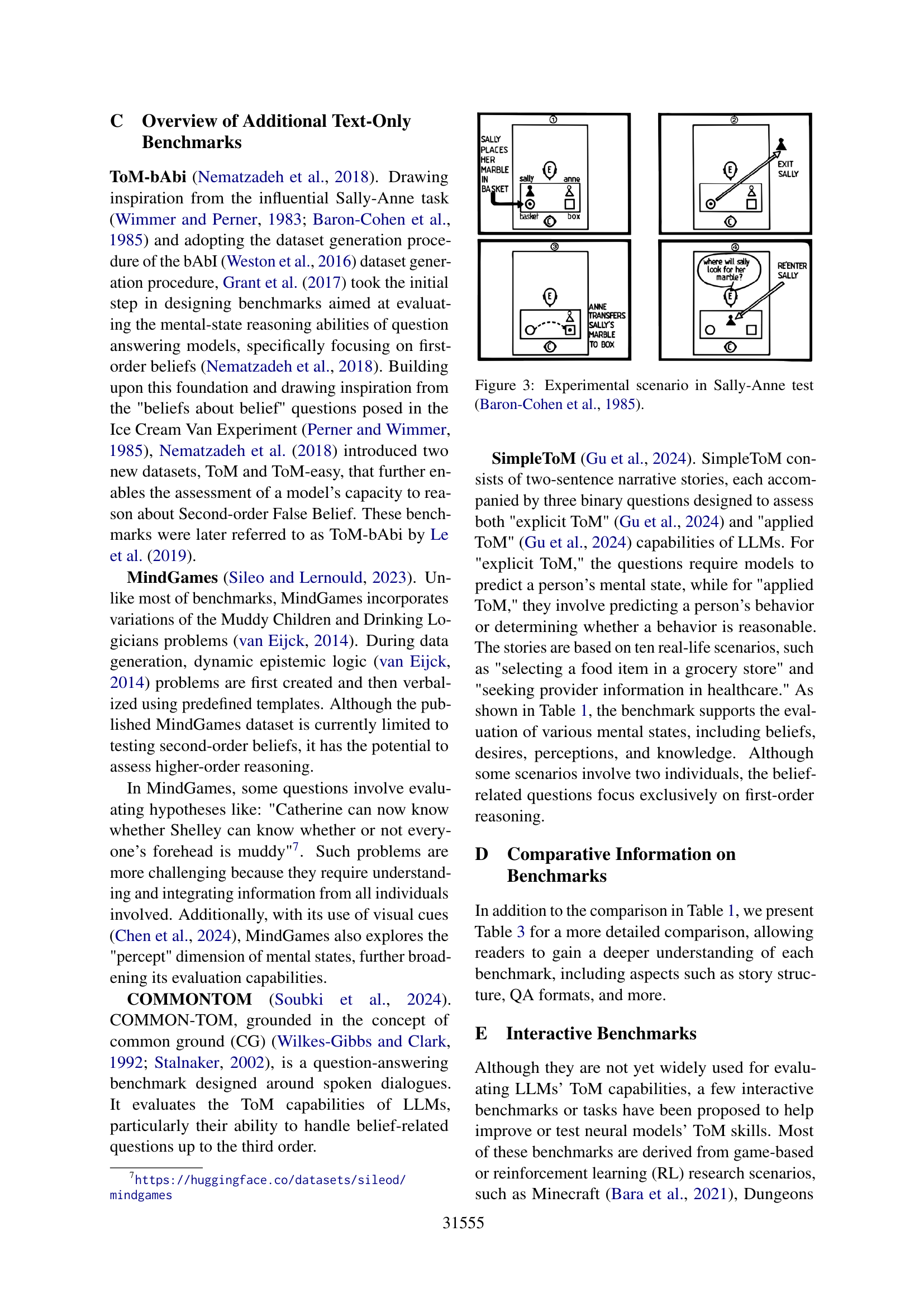

Sally-Anne 测试

图3:经典的 Sally-Anne 测试场景

测试流程:

- Sally 把弹珠放进篮子

- Sally 离开房间

- Anne 把弹珠移到盒子里

- Sally 回来

测试问题:

| 问题类型 | 问题 | 正确答案 |

|---|---|---|

| 信念问题 | Sally 会去哪里找弹珠? | 篮子(她不知道被移走了) |

| 现实问题 | 弹珠真正在哪里? | 盒子 |

| 记忆问题 | 弹珠一开始在哪里? | 篮子 |

关键洞见:4岁儿童通常能通过此测试,表明 ToM 能力在此时发展成熟

Smarties 任务(意外内容任务)

- 向儿童展示一个糖果盒

- 问:里面是什么?(回答:糖果)

- 打开显示实际是铅笔

- 问:另一个没看过的人会认为里面是什么?

- 正确答案:糖果(测试理解他人错误信念的能力)

5.2 纯文本基准对比

| 基准 | 数据来源 | 故事形式 | 问答格式 | 最高阶 | 发表 |

|---|---|---|---|---|---|

| ToMi | Sally-Anne | 叙事 | 开放QA | 2阶 | EMNLP-IJCNLP 2019 |

| HI-TOM | Sally-Anne | 叙事 | 多选 | 4阶 | EMNLP Findings 2023 |

| FANTOM | LLM生成对话 | 对话 | 多种 | 2阶 | EMNLP 2023 |

| BigToM | 因果模板 | 叙事 | 二选一 | 1阶 | NeurIPS 2023 |

| OpenToM | Sally-Anne+性格 | 叙事 | 多选 | 2阶 | ACL 2024 |

| NegotiationToM | CaSiNo谈判 | 对话 | 多选/排序 | 2阶 | EMNLP Findings 2024 |

| TOMBENCH | 从头构建 | 叙事 | 多选 | 2阶 | ACL 2024 |

| SimpleToM | 10种现实场景 | 叙事 | 是/否 | 1阶 | arXiv 2024 |

5.3 心理状态覆盖对比

| 基准 | 信念 | 意图 | 欲望 | 情感 | 知识 | 感知 | 非字面 |

|---|---|---|---|---|---|---|---|

| ToMi | ✓ | ||||||

| HI-TOM | ✓ | ||||||

| FANTOM | ✓ | ||||||

| BigToM | ✓ | ✓ | ✓ | ||||

| OpenToM | ✓ | ✓ | ✓ | ||||

| NegotiationToM | ✓ | ✓ | ✓ | ||||

| TOMBENCH | ✓ | ✓ | ✓ | ✓ | ✓ | ✓ | |

| SimpleToM | ✓ | ✓ | ✓ | ✓ | |||

| MMToM-QA | ✓ | ✓ | |||||

| MuMA-ToM | ✓ | ✓ |

发现:大多数基准集中在信念测试,其他心理状态覆盖不足

5.4 基准演化趋势

2019 ────────────────────────────────────────────> 2025

阶数: 1阶 → 2阶 → 4阶

数据: 模板生成 → LLM生成 → 人工构建(防污染)

语境: 叙事故事 → 多轮对话

语言: 英文 → 中英双语

心理状态:仅信念 → 多种状态

问题: 单一问题 → 多类型问题5.5 多模态基准

MMToM-QA (Jin et al., 2024)

- 首个多模态 ToM 基准

- 结合视频和文本描述家庭环境中的人物活动

- 基于 VirtualHome 仿真环境

- 问题类型:信念推断、目标推断

- 限制:仅单角色、一阶信念

MuMA-ToM (Shi et al., 2025)

- 首个多模态多智能体 ToM 基准

- 问题类型:

- 信念推断

- 社会目标推断

- 目标信念推断(二阶)

- 限制:仅 2 个智能体、3 种社会目标

6. ToM 增强策略详解

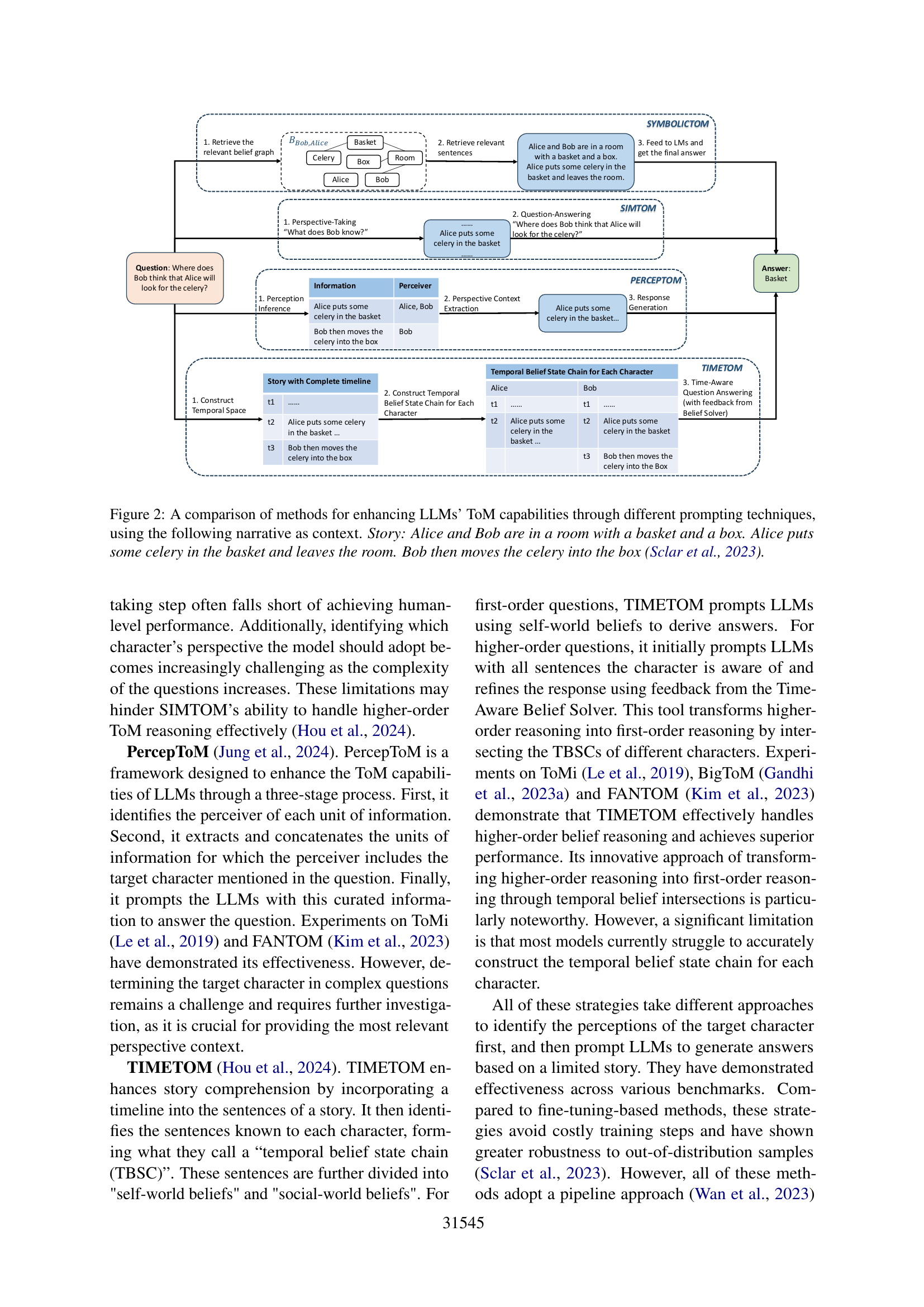

图2:四种基于提示的 ToM 增强方法对比,使用同一个故事场景

6.1 仅依赖提示策略

SYMBOLICTOM (Sclar et al., 2023)

核心思想:为每个角色构建信念图

信念图结构:

├── B_Bob(Bob 的信念)

│ ├── Celery → Basket

│ └── Alice → Room

└── B_Bob,Alice(Bob 认为 Alice 相信的)

└── Celery → Basket

推理流程:

1. 识别问题中的实体

2. 定位相应信念图

3. 检索相关句子

4. 输入 LLM 回答优势:

- 理论上可处理任意阶信念问题

- 在 ToMi 上有效处理三阶问题

局限:

- 内存需求随阶数指数增长

- 信念图质量关键

- 丢失历史信息

SIMTOM (Wilf et al., 2024)

核心思想:基于"模拟理论"的两阶段提示

阶段 1:视角采取(Perspective Taking)

"Bob 知道什么?"

→ 筛选出 Bob 能感知到的事件

阶段 2:问答

用筛选后的情境提示 LLM 回答优势:

- 如果视角采取完美,几乎能解决现有基准

- 概念简洁

局限:

- 视角采取步骤难以达到人类水平

- 高阶问题中识别目标视角困难

PercepToM (Jung et al., 2024)

三阶段框架:

1. 感知推断:识别每条信息的感知者

"Alice puts celery in basket" → 感知者: Alice, Bob

"Bob moves celery to box" → 感知者: Bob

2. 视角语境提取:拼接目标角色能感知的信息

3. 响应生成:用筛选后的语境提示 LLM局限:复杂问题中确定目标角色仍具挑战

TIMETOM (Hou et al., 2024)

创新点:引入时间维度

完整时间线故事:

t1: ...

t2: Alice puts celery in basket

t3: Bob moves celery into box

每个角色的时间信念状态链(TBSC):

Alice: Bob:

t1: ... t1: ...

t2: Alice puts... t2: Alice puts...

t3: Bob moves...

高阶→一阶转换:

通过交叉不同角色的 TBSC 实现优势:

- 创新地将高阶推理转换为一阶

- 在多个基准上取得优异性能

局限:大多数模型难以准确构建 TBSC

6.2 结合额外技术的方法

| 方法 | 额外技术 | 测试阶数 | 是否需要微调 |

|---|---|---|---|

| ToM-LM | 符号执行器 | 2阶 | 是 |

| BIP-ALM | 贝叶斯逆规划 | 1阶 | 是 |

| LIMP | 多智能体逆规划 | 2阶 | 否 |

ToM-LM (Tang & Belle, 2024)

流程:

自然语言描述

↓ LLM 语义解析

符号公式化表示

↓ SMCDEL 模型检查器

验证结果优势:增加透明度和可验证性 局限:需要逻辑专业知识准备微调数据

BIP-ALM (Jin et al., 2024)

贝叶斯逆规划加速语言模型:

输入提取:

- 初始状态、动作(从视频)

- 假设(目标、信念,从问题)

↓

LLM 估计观察到的动作的可能性

↓

微调:用 <状态, 信念, 目标> → 预测动作LIMP (Shi et al., 2025)

语言模型逆多智能体规划:

VLM 提取视频信息 ──┐

├─→ LLM 融合 → 逆多智能体规划

LLM 提取文本信息 ──┘

优于 BIP-ALM:

- 适用于多智能体场景

- 用自然语言表示所有信息(更通用)6.3 方法对比总结

| 方法 | 最高阶 | 微调 | 主要优势 | 主要局限 |

|---|---|---|---|---|

| SYMBOLICTOM | 3阶 | 否 | 任意阶理论支持 | 内存指数增长 |

| SIMTOM | 2阶 | 否 | 概念简洁 | 视角采取不完美 |

| PercepToM | 2阶 | 否 | 显式感知建模 | 目标角色识别难 |

| TIMETOM | 3阶 | 否 | 高阶转一阶 | TBSC 构建难 |

| ToM-LM | 2阶 | 是 | 可验证性 | 需专业知识 |

| BIP-ALM | 1阶 | 是 | 贝叶斯推理 | 仅家庭场景 |

| LIMP | 2阶 | 否 | 多智能体 | VLM 幻觉问题 |

共同问题:

- 所有方法都采用流水线架构

- 错误传播是主要问题

- 首步准确性至关重要

7. 未来研究方向

7.1 基准与策略共同方向

| 方向 | 说明 |

|---|---|

| 扩展心理状态范围 | 当前集中在信念,需要覆盖更多状态 |

| 多模态 ToM 推理 | 结合视觉、听觉、上下文等多种线索 |

| 主动基准与智能体决策 | 从被动观察者转向主动智能体 |

7.2 策略特定方向

| 方向 | 说明 |

|---|---|

| 探索联合方法 | 引入反馈循环,减少错误传播 |

| 渐进学习策略 | 从简单任务逐步过渡到复杂任务 |

| 评估推理过程 | 不仅评估答案正确性,还评估推理过程 |

7.3 其他方向

- 多语言基准:目前大多为英文,需要多语言支持

- 高阶 ToM 推理:推进到三阶、四阶甚至更高

- 小模型 ToM 能力:大多数策略在 7B+ 模型测试,小模型研究不足

8. 交互式基准候选

论文附录中介绍了几个潜在的交互式评估基准:

| 基准 | 环境 | 特点 |

|---|---|---|

| MINDCRAFT | Minecraft | 两方合作,非对称知识 |

| SymmToM | 网格世界 | 对称多智能体,信息收集游戏 |

| G-DRAGON | 龙与地下城 | 意图驱动的自然语言生成 |

| Situated ToM | MiniGrid | 覆盖 ATOMS 所有方面 |

9. 核心洞见

9.1 LLM 的 ToM 能力现状

当前状态:

┌────────────────────────────────────────────┐

│ LLM 在 ToM 任务上表现不稳定 │

│ - 简单变体可能导致失败 │

│ - 高阶推理能力有限 │

│ - 跨基准一致性差 │

└────────────────────────────────────────────┘9.2 评估的核心挑战

- ToM 本质复杂:无法通过有限问题完全捕获

- 数据污染风险:LLM 可能在训练中见过测试数据

- 评估方法多样:不同基准结果难以比较

- 多选题局限:难以判断 LLM 是否真正理解

9.3 增强策略的共同模式

所有方法的核心思路:

原始故事 → 识别目标角色感知 → 筛选相关信息 → 提示 LLM

变体差异在于:

- 如何表示感知(图/列表/时间链)

- 如何筛选信息(规则/学习)

- 是否引入外部工具(符号求解器/贝叶斯推理)10. 实践建议

10.1 选择评估基准

| 需求 | 推荐基准 |

|---|---|

| 快速评估基本 ToM | ToMi、BigToM |

| 高阶信念测试 | HI-TOM(最高4阶) |

| 全面心理状态覆盖 | TOMBENCH |

| 对话场景 | FANTOM、NegotiationToM |

| 多模态 | MMToM-QA、MuMA-ToM |

| 中文支持 | TOMBENCH |

10.2 选择增强策略

| 场景 | 推荐策略 |

|---|---|

| 无需微调、快速部署 | SIMTOM、PercepToM |

| 高阶推理需求 | TIMETOM、SYMBOLICTOM |

| 多模态输入 | LIMP |

| 需要可解释性 | ToM-LM(符号推理) |

11. 相关资源

主要基准链接

| 基准 | 链接 |

|---|---|

| ToMi | GitHub |

| HI-TOM | GitHub |

| FANTOM | GitHub |

| TOMBENCH | GitHub |

| MMToM-QA | 项目页 |

相关综述

- Ma et al. (2023b): "Towards a holistic landscape of situated theory of mind in large language models"

联系方式

- 第一作者: Ruirui Chen (A*STAR IHPC)

- 通讯作者: Cheston Tan (A*STAR CFAR)

本解读文档基于 ACL 2025 论文生成,旨在帮助中文读者全面了解 LLM 心智理论研究的最新进展。